La singularité de la technique, c’est peut-être d’avoir l’air objectif et intemporel quand la réalité démontre tout le contraire : elle obéit comme le reste à l’histoire et aux conventions. André Gunthert revient sur les arguments qui pourraient nous inviter à rallier le terrain de l’histoire déserté par les partisans du formalisme. A travers des exemples connus auxquels nous n’avions jamais vraiment prêté attention sous l’angle de la technique, il rappelle que toute opération d’enregistrement perçue comme transparente au moment où elle s’effectue a tendance à s’opacifier au fur et à mesure que cette opération s’éloigne dans le temps. En fait, la redéfinition de la technique n’a pas de fin ni les variations du goût par nature provisoire dont elles dépendent. Rien n’a lieu sans un minimum de consensus historique dont le plus durable est bien de voir garantir tous les aspects d’immédiateté et de transparence possibles.

Christian Walter étend la réflexion sur la fausse neutralité de la technique à l’économie. En l’occurrence, il montre qu’un marché dépend de son enregistrement. La crise boursière récente lui aurait donné raison quand il insiste sur la nature de l’appréhension de l’incertitude du monde économique et financier, par une modélisation probabiliste datée des années 1960 et reposant sur des conceptions statistiques héritées du 19e siècle. Selon lui, les pratiques qui en découlent seraient inaptes à prendre en considération des phénomènes actuels majeurs : les emballements de l’opinion et les crises de liquidité. Plaidant pour « une bonne image » de l’incertitude, il éclaire le rôle de la représentation, en économie comme ailleurs.

Les deux auteurs démontrent chacun à leur façon, en partant d’objets très différents, combien la technique joue un rôle puissant : faussement innocente, elle gagne aussi longtemps que le spectateur n’a pas envie de savoir ce qui se cache derrière ses filtres.

Laurence Bertrand Dorléac

Séminaire du 13 décembre 2007

L’un des traits caractéristiques de la finance contemporaine est sa massive mathématisation : des modèles mathématiques de marché dont l’objectif est la mise en équation des trajectoires boursières construisent socialement un monde d’échanges permanents dans lesquels le calcul de la valeur des choses devient une convention fondatrice de ces échanges : prix d’options, prix d’actions, mais aussi prix du courant électrique ou prix du temps qu’il fera demain à Paris ou à New York, rien n’échappe à l’extension mathématique de la finance contemporaine, et réciproquement, cette financiarisation massive du monde repose ultimement sur la validité partagée de modèles mathématiques puissants, implémentés dans les systèmes informatiques des acteurs financiers, mais aussi et surtout, encastrés cognitivement dans leurs manières de penser la réalité. Il est tout à fait remarquable d’observer la profondeur de cet encastrement cognitif chez ceux-là même qui se défient le plus des modèles et qui affirment de manière forte qu’ils en sont exempts, comme les professionnels de la gestion d’actifs dite classique. Ces modèles ont pour objectif principal la quantification de l’incertitude et sa transformation en loi de probabilité. L’image de l’incertitude donnée par les mouvements des bourses devient alors le support du calibrage du risque des positions de marché, et les pratiques professionnelles concrètes instrumentent très profondément ce calibrage probabiliste jusque dans les schémas organisationnels des banques ou sociétés de gestion d’actifs. Les réglementations internationales solidifient ensuite en des normes professionnelles contraignantes la conception de l’incertitude issue de la modélisation probabiliste des fluctuations des bourses.

Devant la profondeur de cette pénétration intellectuelle, il peut être intéressant voire socialement utile d’interroger les bases conceptuelles de ces modèles probabilistes. En effet, cette mise en équation (comme ce calcul de valeur) représentent en fait le résultat d’une opération intellectuelle totalement non triviale de double reconstruction du monde financier : une reconstruction empirique d’abord, une reconstruction théorique ensuite. Reconstruction empirique : l’image du marché qui transparaît sur les graphiques de fluctuations des bourses dépend des manières de se saisir des données de cotation boursière, et donc des technologies d’enregistrement de ces données. Reconstruction théorique : les choix de modèles mathématiques s’appuient sur l’image produite par les enregistrements, qui servent ensuite à valider statistiquement les choix probabilistes effectués dans ces modèles. A l’issue du processus de double reconstruction du monde, on pourrait dire que l’on a remplacé le marché réel par son image supposée le représenter adéquatement mais, plus précisément, il serait plus juste de dire que l’on a construit socialement un monde financier qui repose sur la perception d’une image de ses fluctuations. Allons voir de plus près ce qu’il en est.

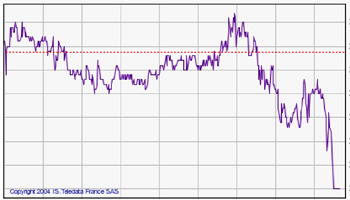

Graphique 1 : fluctuations boursières à l’échelle microscopique des transactions

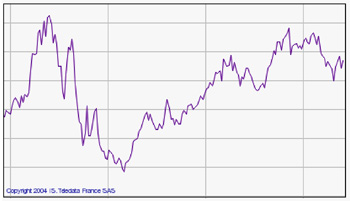

La composante élémentaire de l’enregistrement est la cotation d’un titre au moment de l’échange. On relève cette cotation à chaque échange et on construit ainsi une série de cours qui, reliés entre eux, dessinent une trajectoire boursière : celle de l’évolution dans le temps de l’actif négocié (graphique 1). L’horloge (ou calendrier) de la mesure des fluctuations est ici constituée par la succession des dates de cotations : c’est donc un temps intrinsèque au marché, le « temps de l’échange », et non le temps calendaire « physique ». A partir de ces données de base, on peut ensuite construire une nouvelle série de données par agrégation simple : en additionnant les variations successives des cours pris échange par échange, on obtient les variations successives des cours pris tous les deux échanges, puis tous les trois, etc. jusqu’à obtenir des séries chronologiques de cours quotidiens, hebdomadaires, mensuels, puis annuels (graphique 2). Cette nouvelle série est construite selon un temps qui cette fois n’est plus le temps intrinsèque mais le temps physique, ou le « temps de tout le monde », par opposition au temps précédent qui serait plutôt le « temps de quelques uns ».

Graphique 2 : fluctuations boursières à l’échelle macroscopique des économies

Les données de base (cotation par cotation) sont des données de haute fréquence, ou encore de haute résolution de l’image du marché. Tandis que les données agrégées (par exemple annuelles) sont des données de basse fréquence, ou de basse résolution de l’image du marché. Bien comprendre ces données de haute fréquence nécessite d’avoir accès à une théorie de la microstructure du marché (qui détient quoi en portefeuille, comment se vident les carnets d’ordre etc.). On se trouve ici sur l’échelle microscopique de la formation des prix dans l’espace social réduit du marché. En revanche, les données de basse fréquence permettront davantage des comparaisons des variations boursières aux variations des quantités économiques classiques (PIB etc.) : on se trouve ici sur l’échelle macroscopique des Etats et des politiques économiques, dans un autre espace social. Y a-t-il une « bonne » échelle de l’observation des marchés, une bonne distance à l’image de la trajectoire boursière ? Lorsqu’on contemple un tableau ou une photographie, la distance d’observation devient un élément important de l’appréciation de la représentation. Doit-on être près ou loin de la trajectoire boursière (graphique 3) ? Doit-on chercher à scruter les détails de la peinture boursière, ou peut-on se contenter de ses formes d’ensemble ?

Poursuivons l’analogie photographique : en basse résolution, les images apparaissent floues lorsqu’elles sont agrandies (ou « pixellisés»). La basse résolution représente une perte d’information sur l’objet photographié. Qu’en est-il du marché ? Perd-on de l’information en passant des données de haute fréquence aux données de basse fréquence ? La réponse est donnée par la théorie des fractales de Mandelbrot : si les variations boursières sont fractales, alors le choix de l’échelle de résolution n’a pas d’incidence sur l’obtention de l’information. Il y a invariance par changement d’échelle et la structure des détails ne disparaît pas lorsqu’on change la distance à l’image. Une fractale conserve ses détails à toutes les échelles. Dans le cas contraire, le changement de résolution induit nécessairement un changement d’image de l’incertitude donc d’accès à l’information.

Poursuivons l’analogie photographique : en basse résolution, les images apparaissent floues lorsqu’elles sont agrandies (ou « pixellisés»). La basse résolution représente une perte d’information sur l’objet photographié. Qu’en est-il du marché ? Perd-on de l’information en passant des données de haute fréquence aux données de basse fréquence ? La réponse est donnée par la théorie des fractales de Mandelbrot : si les variations boursières sont fractales, alors le choix de l’échelle de résolution n’a pas d’incidence sur l’obtention de l’information. Il y a invariance par changement d’échelle et la structure des détails ne disparaît pas lorsqu’on change la distance à l’image. Une fractale conserve ses détails à toutes les échelles. Dans le cas contraire, le changement de résolution induit nécessairement un changement d’image de l’incertitude donc d’accès à l’information.

Graphique 3 : Changements d’échelle et zooms selon la technologie d’enregistrement sur l’action Alcatel. a) de 7 ans à 2 ans ; b) de 2 ans à 4 jours.

Il est apparu que les images de l’incertitude issues du traitement statistique des données de haute fréquence ne correspondaient pas à celles issues du traitement statistique des données de basse fréquence. La théorie des fractales ne s’applique pas uniformément ou de manière directe sur les variations de cours.

Les technologies d’enregistrement ont varié au cours du temps avec le développement de l’électronique et de la puissance des ordinateurs. Dans les années 1930, les données étaient trimestrielles. Elles sont devenues quotidiennes dans les années 1970, puis intraquotidiennes dans les années 1990. Or, au moment de l’enregistrement des données, la technologie est invisible et transparente : l’état du dispositif technique disparaît donc dans la construction des modèles probabilistes. Mais ensuite, son obsolescence la rend apparente. Entre les deux époques d’enregistrement, on ne voit pas le marché de la même manière, ou pas le même marché. C’est ainsi que les nouvelles technologies ont conduit à une modification substantielle de la compréhension des variations boursières et donc, comme on l’a compris, de l’image de l’incertitude affectant les mouvements des marchés. De nouveaux modèles probabilistes sont apparus dans les années 1990, représentant plus fidèlement ce que l’on voyait et qu’on ne voyait pas auparavant, nouvelle vision des marchés qui a conduit à une nouvelle conceptualisation du risque.

Pourtant, dans les milieux professionnels financiers, on a observé une résistance à ce changement de conceptualisation, avec d’une part, la conservation de modèles probabilistes non adaptés à la nouvelle image de l’incertitude et d’autre part, de manière plus insidieuse, à un maintien d’un encastrement cognitif dans l’ancienne conception issue de la technologie des années 1960. Les crises financières que l’on a connues récemment viennent en partie de cet écart entre l’image renouvelée de l’incertitude et le maintien de modélisations probabilistes issues d’une image (donc d’une technologie d’enregistrement) plus ancienne : conflit de technologies d’enregistrement, ou autre chose ? On n’y voit rien, ou on ne veut rien voir ?

Cette question conduit à repenser la notion de temps, et donc de vitesse adéquate de visionnage du film du marché. Tel l’accéléré ou le ralenti dans les films cinématographiques, le temps de l’échange semble se dilater ou se contracter selon l’activité boursière. Le risque financier dépend de ces pulsations temporelles, et la navigation des meilleurs gérants de portefeuille (comme Warren Buffet) sur ces vagues chronologiques montre qu’ils savent utiliser comme repère le temps social (ou le chairos) et non le temps physique (ou le chronos). Pour eux, une semaine de bourse peut durer moins qu’une matinée agitée. Le temps de l’échange serait-il irréductible au temps calendaire ? Sur les marchés, il semblerait que, comme dit le psalmiste, mille ans sont comme un jour et un jour est comme mille ans.

Bibliographie

LÉVY VÉHEL, J., WALTER, C., Les marchés fractals, PUF, 2002.

WALTER, C., BRIAN, E. (dir.), Critique de la valeur fondamentale, Springer, 2007.

Christian Walter, ESSEC, actuaire agrégé de l’IAF, docteur en économie, habilité à diriger des recherches, est professeur des universités associé à Sciences Po et consultant. Ses travaux portent sur la modélisation financière, ainsi que sur l’histoire et l’épistémologie de la théorie de la finance. Expérience professionnelle de vingt ans dans la gestion d’actifs et le contrôle des risques (CCF, BBL, SBS, Crédit Lyonnais, Pricewaterhouse Coopers). Membre du conseil scientifique de l’Association française de la gestion financière (AFG).